- por Manuel Llaca

- 07 Mayo, 2016

- Artículo

- 12.995

- 2

- Actualizado el 27 Julio, 2022

Todo tiene un límite, y el modelo actual de la informática hace tiempo que ha agotado su espacio... solo sobrevive mediante remiendos. Y el problema que, en teoría se encontraría en el hardware, en realidad se encuentra en el software.

En realidad la informática nació en el año 1954, coincidiendo con la presentación del primer transistor de silicio comercial desarrollado por Texas Instruments. Antes de 1954, quizás muchos siglos antes, físicos, químicos, y matemáticos, empezaron a allanar el camino teórico y práctico para la creación de la informática, con aportaciones como la «Álgebra de Boole», máquinas que vapor para realizar cálculos, o máquinas complejas y gigantescas rellenas de «relés» y «válvulas de vacío». Precisamente los transistores fabricados con materiales semiconductores provocaron el ocaso de la tecnología de válvulas de vacío, que fue tecnología «punta» durante un breve espacio de tiempo.

En el año 1925 se conocieron las primeras investigaciones sobre transistores, pero no fue hasta el año 1954 cuando se presentó el primer transistor comercial de silicio, y ahí, realmente ahí, empezó la nueva era de la informática; la era donde la informática sería viable para los pequeños procesos, y sería definitivamente global... accesible a todo el mundo. Se creó el nuevo modelo computacional basado en el transistor.

Pero todo tiene un límite, y el modelo actual hace tiempo que ha agotado su espacio. Solo sobrevive mediante remiendos ¿Dónde está el problema? Parece evidente que debiera estar en el hardware. Pues no; está en el software. Henry Petrosky dijo: «el logro más impresionante de la industria del software es la continua anulación de los constantes y asombrosos logros de la industria del hardware». Ahí radica el problema, según se progresa en la evolución del hardware, entonces queremos que el software llegue mucho más lejos, y en seguida se satura la nueva tecnología; el software, cual parásito, deja siempre a cero la evolución del hardware.

...aquellos ordenadores de 8 bits sí podían ejecutar algunos sistemas operativos...

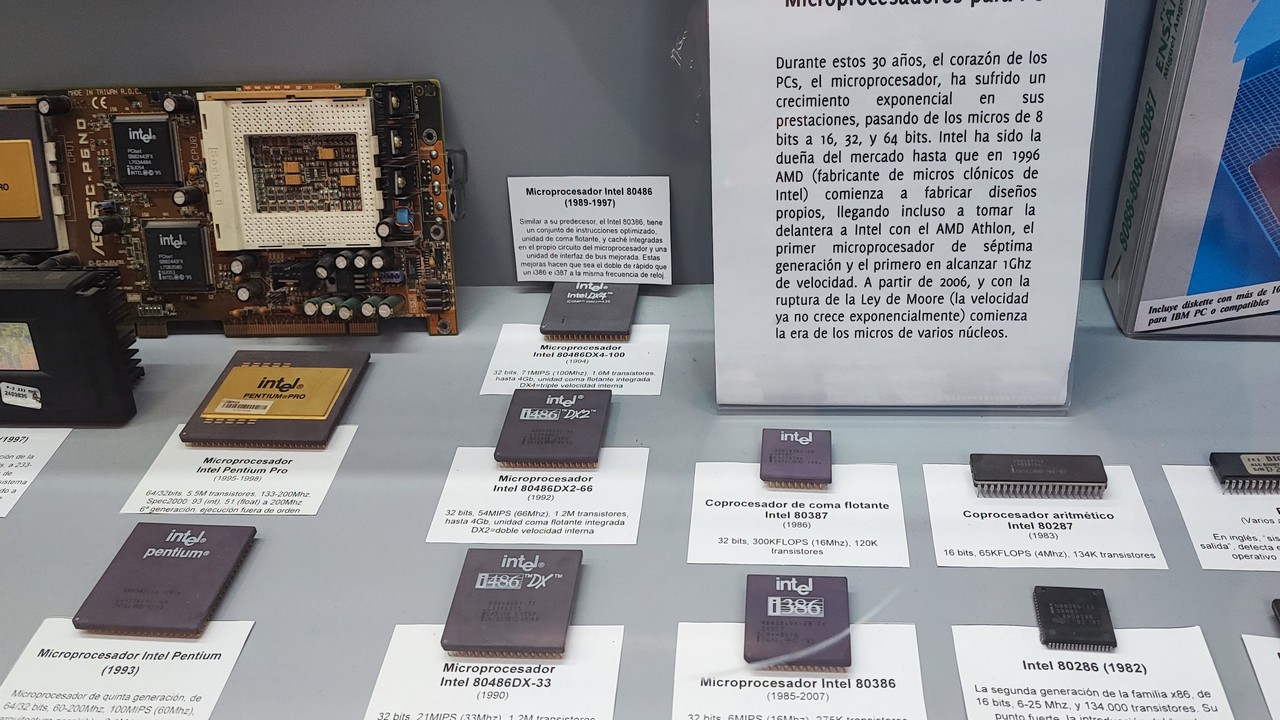

En el año 1965 Gordon Moore definió lo que a posteriori se calificaría como la «Ley de Moore»: «aproximadamente cada dos años se duplica el número de transistores en un microprocesador»...el truco está en fabricar más cantidad de transistores en menor espacio...

La evolución del software requiere procesadores más rápidos, y el truco está en fabricar más cantidad de transistores en menor espacio. La evolución de la tecnología ha permitido aumentar la escala de integración y esto implica poder construir transistores más pequeños en menor espacio en el interior de los microprocesadores... cuánto más pequeño es el microprocesador y más transistores contiene, es más rápido.

En la actualidad, estamos en la escala de fabricación de nanómetros, y en ese momento nos hemos topado con el primer muro: los electrones se escapan de los canales por los que circulan; se conoce como el «efecto túnel». A este problema hemos de sumar que el silicio cuenta con otros problemas físicos, como la barrera de los 4Ghz de velocidad, ya que a partir de esa frecuencia el material no podría soportar el calor generado.

...hemos llegado al límite del modelo actual de hardware.

En los comienzos del milenio en el que nos encontramos hemos llegado al límite del modelo actual de hardware; la Ley de Moore parece extinguirse, y el software deberá contener su desarrollo.

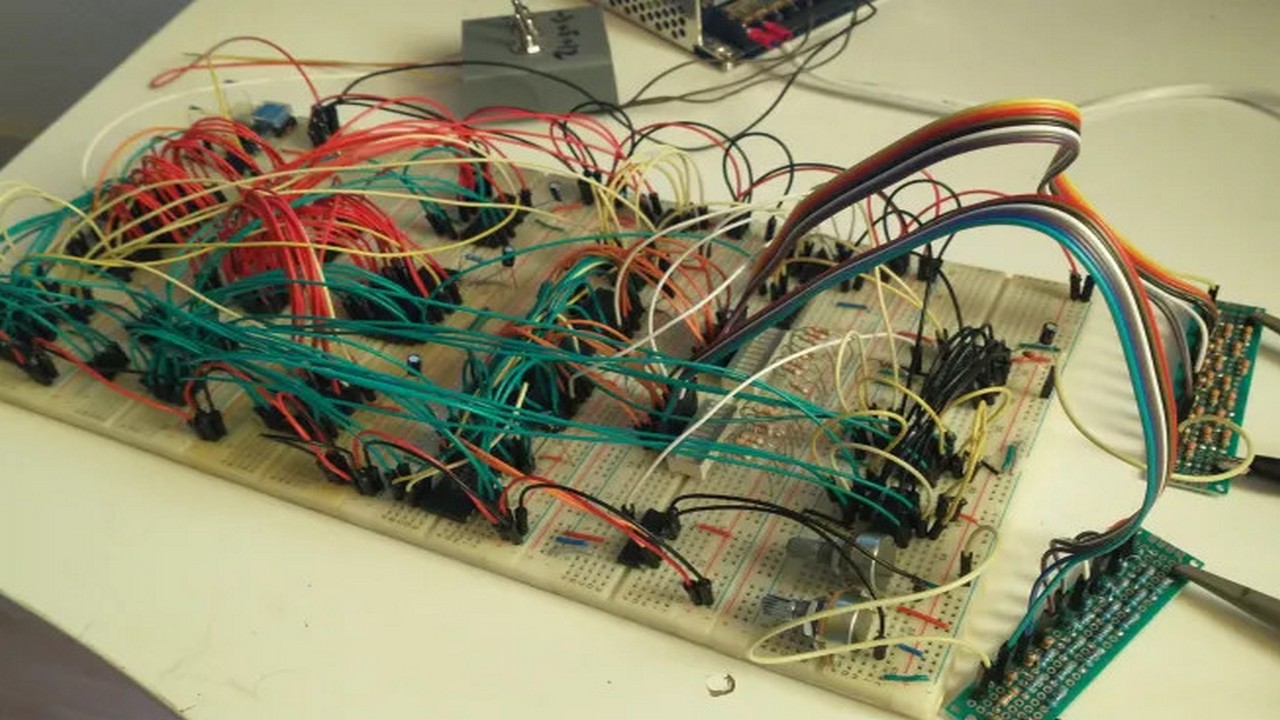

Pero la informática encontró el remiendo perfecto, la ejecución en paralelo. Si un microprocesador no puede superar los limites actuales, se agrupan varios de ellos para trabajar en paralelo. Así nacen los procesadores de varios núcleos con varios hilos de ejecución; no son más rápidos, pero si ejecutan más rápido. Y los algoritmos se ejecutan en paralelo por separado en el mismo instante. Y así estamos en la actualidad, hablando de procesadores de ocho núcleos con dos hilos de ejecución por núcleo (por ejemplo). El remiendo perfecto da las bocanadas de aire suficientes para que el «software» siga día a día creciendo para ejecutar procesos más complejos hasta volver a saturar de nuevo a la tecnología.

...grafeno, ordenadores cuánticos, etcétera... todo está muy verde...

Hay otras alternativas bajo investigación para crear nuevos modelos de computación que sustituyan el que se está «auto-extinguiendo», como por ejemplo el «Grafeno» o los «procesadores cuánticos», pero todo está muy verde, y todavía no hay ninguna certeza de que ninguno de ellos sea viable en el futuro. Así que el modelo actual seguirá buscando los «remiendos perfectos» y otros caminos alternativos.

Último Artículo

- 21 Noviembre, 2025

- Artículo

Último Videoblog

- 02 Marzo, 2026

- 23:49

- Videoblog

Último Podcast

- 24 Febrero, 2026

- 34:18

- Podcast

Último Vídeo corto

- 26 Diciembre, 2025

- 02:32

- Vídeo corto

-...no es hasta el año 1954 cuando se presenta el primer transistor comercial de silicio.