- por Manuel Llaca

- 18 Diciembre, 2016

- Artículo

- 8.186

- 1

- Actualizado el 11 Mayo, 2022

En los años noventa, con la llegada del ordenador clónico a los hogares, y con los ordenadores adquiridos por piezas y ensamblados por los propios usuarios, nació la técnica del overclocking para aumentar la frecuencia del ordenador.

En los años noventa, con la aparición de los ordenadores clónicos y la evolución de la arquitectura del IBM PC original, se extendió rápidamente una práctica conocida con el nombre de «overclocking» que hacía referencia al método seguido para forzar el rendimiento del sistema con el objeto de aumentar la velocidad del ordenador. En los últimos años del siglo pasado fue una práctica muy habitual en aquellos usuarios de informática que contaban con los suficientes conocimientos de hardware para ejecutar el proceso con éxito.

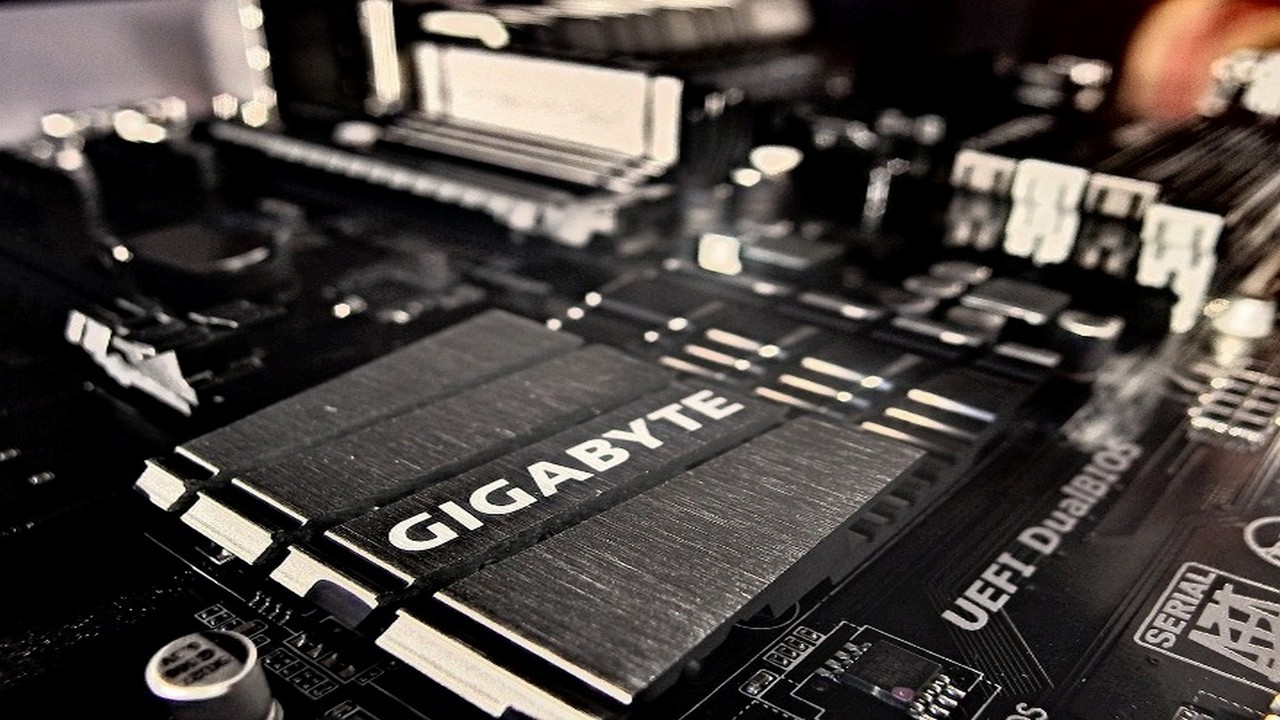

Los ordenadores basados en la arquitectura IBM PC forman un sistema, o un conjunto, que debe funcionar en armonía dirigido por la batuta de un ciclo de reloj que marca los tiempos. Cuando hablamos de la velocidad de un ordenador, que en la década de los noventa era determinada mediante «megahercios» y actualmente se mide en «gigahercios», normalmente solo se tiene en cuenta la velocidad del microprocesador... o en la actualidad se tiene en cuenta la velocidad de cada núcleo que forma el conjunto del microprocesador. Pero en el sistema existen muchas velocidades diferentes: la del FSB («Front Side Bus»), la de la tarjeta gráfica, la de la memoria RAM, etcétera.

La velocidad FSB es la velocidad a la que circulan los impulsos eléctricos por el bus, que son los canales de comunicación de todos los dispositivos que forman el ordenador. Por lo tanto podríamos afirmar que es la velocidad de la placa base del ordenador.

En los ordenadores de arquitectura PC, normalmente, las placas base son fabricadas para que funcionen sobre ellas una amplia variedad de microprocesadores de un mismo fabricante, y el método para elegir la configuración adecuada pasa por seleccionar la velocidad correcta de la placa base o FSB, y después un multiplicador que determina la relación entre la velocidad de la placa base y la velocidad del microprocesador.

Al seleccionar la velocidad en la placa base a 100 Mhz, posteriormente se debía seleccionar el multiplicador «4x» al configurar el microprocesador.

Pongamos un ejemplo: Un ordenador del año 2000 que contaba con un microprocesador Intel Pentium III de 400 Mhz de velocidad era montado sobre una placa base con una velocidad FSB de 100 Mhz. Por lo tanto al seleccionar la velocidad en la placa base a 100 Mhz, posteriormente se debía seleccionar el multiplicador «4x» al configurar el microprocesador. Al multiplicar ambos se obtenían los 400 Mhz de velocidad para los que fue fabricado el procesador.

Los métodos para realizar la configuración eran diversos. El más habitual era la configuración vía hardware, ya que la mayoría de placas base, en su electrónica, contaban con un par de «jumpers» o puentes que permitían seleccionar la velocidad del FSB y el multiplicador. Por lo tanto era necesario abrir el ordenador y utilizar unas pinzas estilo «depilación»...

Otro método era la configuración desde la «BIOS» del sistema desde los menús de configuración accesibles al arrancar el ordenador, por lo que no era necesario abrir el ordenador y revolver en la electrónica. Esto era así porque muchos fabricantes incorporaban la configuración vía software en lugar de hardware.

También existían placas base que auto-detectaban la velocidad FSB y el multiplicador, por lo que eran componentes electrónicos a los cuales no se les podía realizar un «overclocking». Este tercer caso era muy poco habitual.

Muchos usuarios de informática buscaban obtener un mayor rendimiento al sistema en sus ordenadores, y la práctica del «overclocking» comenzó a ser algo habitual ¿Cómo lo hacían? Sigamos el ejemplo iniciado anteriormente.

Con el «overclocking» nuestro sistema va a consumir más energía, y el calor generado -y por tanto desprendido- por los componentes será mayor... el sistema puede volverse inestable.

Si a nuestro ordenador Intel Pentium III de 400 Mhz de velocidad le modificamos algunos valores, forzamos la velocidad en el sistema. Por ejemplo, vamos a seleccionar 110 Mhz de FSB en lugar de 100 Mhz, y 4.5x de multiplicador en lugar de 4x. Al cambiar los «jumpers» o la configuración de la «BIOS», pasamos de operar a 400 Mhz a trabajar sobre una velocidad de 495 Mhz. En total 95 Mhz extra. Pero... ¡cuidado!... nuestro sistema va a consumir más energía, y el calor generado -y por tanto desprendido- por los componentes será mayor... el sistema puede volverse inestable.

Un microprocesador está diseñado para operar bajo unas condiciones concretas, si es forzado, la emisión extra de calor por el aumento de tráfico y consumo energético podría provocar daños irreversibles. Para ejecutar un «overclocking» era necesario tomar algunas medidas como eran:

- No configurar velocidades exageradas; la diferencia entre la velocidad real y la forzada no debía ser grande. Normalmente el «overclocking» seleccionado debía ser «un poco» superior a la velocidad real para la que fue diseñado.

- Se debían tomar medidas extra de refrigeración, y las medidas eran tomadas en función al grado de «overclocking» seleccionado. Se podían incluir ventiladores extra, ventiladores y disipadores de mayor tamaño, refrigeración por agua, o incluso incorporar una refrigeración por célula Peltier.

Con la ejecución de los métodos de «overclocking» muchos usuarios dañaron componentes y «frieron» literalmente sus sistemas, por lo que siempre era una práctica peligrosa, sobre todo si no se contaba con un buen conocimiento de lo que se estaba haciendo. Y aun contando el conocimiento el riesgo existía también, aunque quizás en menor grado. También es necesario tener en cuenta que si el «overclocking» a ejecutar implicaba gastar dinero en medidas de seguridad como la refrigeración, quizás fuera más rentable adquirir un ordenador más rápido. El «overclocking» no siempre compensaba.

Los medios electrónicos portables como los móviles y las «tablets» redujeron las necesidades de uso de los ordenadores de arquitectura PC.

Con el paso de los años, el «overclocking» fue perdiendo fuerza debido a varios factores. En primer lugar porque los precios del hardware informático se vieron reducidos con el paso de los años. En segundo lugar porque los medios electrónicos portables como los móviles y las «tablets» redujeron las necesidades de uso de los ordenadores de arquitectura PC.

Último Artículo

- 21 Noviembre, 2025

- Artículo

Último Videoblog

- 16 Febrero, 2026

- 24:17

- Videoblog

Último Podcast

- 16 Febrero, 2026

- 25:11

- Podcast

Último Vídeo corto

- 26 Diciembre, 2025

- 02:32

- Vídeo corto

En el sistema existen muchas velocidades diferentes: la del FSB («Front Side Bus»), la de la tarjeta gráfica, la de la memoria RAM...